- Количество информации как мера уменьшения неопределенности знаний

- Единицы измерения количества информации

- Определение количества информации, представленной с помощью знаковых систем

- Вопросы к разделу 1

- Энтропия дискретного источника с независимым выбором сообщений

- В каком виде существует информация?

- Как передаётся информация?

- Как измеряется количество информации?

Количество информации как мера уменьшения

неопределенности знаний

Количество информации как мера

уменьшения неопределенности знаний.

Информацию, которую получает человек,

можно считать мерой уменьшения

неопределенности знаний. Если некоторое

сообщение приводит к уменьшению

неопределенности наших знаний, то можно

говорить, что такое сообщение содержит

информацию.

Сообщения обычно содержат информацию

о каких-либо событиях. Количество

информации для событий с различными

вероятностями определяется по формуле:

где

I – количество информации,

N – количество возможных событий,

pi- вероятности отдельных событий.

Если события равновероятны, то количество

информации определяется по формуле:

или

из показательного уравнения:

Пример 2.1. После экзамена по

информатике, который сдавали ваши

друзья, объявляются оценки («2», «3», «4»

или «5»). Какое количество информации

будет нести сообщение об оценке учащегося

A, который выучил лишь

половину билетов, и сообщение об оценке

учащегося B, который выучил

все билеты.

I = log24 = 2 бит

На основании опыта можно также

предположить, что для учащегося B

наиболее вероятной оценкой является

«5» (p1 = 1/2), вероятность оценки «4»

в два раза меньше (p2 = 1/4), а вероятности

оценок «2» и «3» еще в два раза меньше

(p3 = p4 = 1/8). Так как события

неравновероятны, воспользуемся для

подсчета количества информации в

сообщении формулой 2.1:

I = -(1/2Elog21/2

+ 1/4Elog21/4

+ 1/8Elog21/8

+ 1/8Elog21/8)

бит = 1,75 бит

Вычисления показали, что при равновероятных

событиях мы получаем большее количество

информации, чем при неравновероятных

событиях.

Пример 2.2. В непрозрачном мешочке

хранятся 10 белых, 20 красных, 30 синих и

40 зеленых шариков. Какое количество

информации будет содержать зрительное

сообщение о цвете вынутого шарика.

Так как количество шариков различных

цветов неодинаково, то зрительные

сообщения о цвете вынутого из мешочка

шарика также различаются и равны

количеству шариков данного цвета

деленному на общее количество шариков:

pб = 0,1; pк =

0,2; pз =

0,3; pс =

0,4

I = -(0,1·log2

0,1+ 0,2·log2

0,2 + 0,3·log2

0,3 + 0,4·log2

0,4) бит

Пример 2.3. Какое количество вопросов

достаточно задать вашему собеседнику,

чтобы наверняка определить месяц, в

котором он родился?

Будем рассматривать 12 месяцев как 12

возможных событий. Если спрашивать о

конкретном месяце рождения, то, возможно,

придется задать 11 вопросов (если на 11

первых вопросов был получен отрицательный

ответ, то 12-й задавать не обязательно,

так как он и будет правильным).

Правильно задавать «двоичные» вопросы,

т.е. вопросы, на которые можно ответить

только «Да» или «Нет». Например, «Вы

родились во второй половине года?».

Каждый такой вопрос разбивает множество

вариантов на два подмножества: одно

соответствует ответу «Да», а другое —

ответу «Нет».

Правильная стратегия состоит в том,

что вопросы нужно задавать так, чтобы

количество возможных вариантов каждый

раз уменьшалось вдвое. Тогда количество

возможных событий в каждом из полученных

подмножеств будет одинаково и их

отгадывание равновероятно. В этом случае

на каждом шаге ответ («Да» или «Нет»)

будет нести максимальное количество

информации (1 бит).

По формуле 2.2 и с помощью калькулятора

получаем:

I =

log212

» 3,6 бит

Количество полученных бит информации

соответствует количеству заданных

вопросов, однако количество вопросов

не может быть нецелым числом. Округляем

до большего целого числа и получаем

ответ: при правильной стратегии необходимо

задать не более 4 вопросов.

Единицы

измерения количества информации

Единицы измерения количества информации.

За единицу количества информации принят

1 бит — количество информации, содержащееся

в сообщении, уменьшающем неопределенность

знаний в два раза.

Принята следующая система единиц

измерения количества информации:

1 байт = 8 бит

1 Кбайт = 210 байт

1 Мбайт = 210 Кбайт = 220 байт

1 Гбайт = 210 Мбайт = 220 Кбайт

= 230 байт

Определение количества информации,

представленной с помощью знаковых

систем

Если рассматривать символы алфавита

как множество возможных сообщений

(событий) N, то количество

информации, которое несет один знак

можно определить из формулы 2.1. Если

считать появление каждого знака алфавита

в тексте событиями равновероятными, то

для определения количества информации

можно воспользоваться формулой 2.2 или

уравнением 2.3.

Количество информации, которое несет

один знак алфавита тем больше, чем больше

знаков входят в этот алфавит, т.е. чем

больше мощность алфавита.

Количество информации, содержащейся в

сообщении, закодированном с помощью

знаковой системы, равно количеству

информации, которое несет один знак,

умноженному на число знаков в сообщении.

Пример 2.5. Какова мощность алфавита,

с помощью которого записано сообщение,

содержащее 2048 символов, если его объем

составляет 1,25 Кбайта.

Перевести информационный объем сообщения

в биты:

.I = 10 240 бит

Определить количество бит, приходящееся

на один символ:

10 240 бит : 2 048 = 5 бит

По

формуле 2.3 определить количество символов

в алфавите:

N = 2I

= 25 = 32

Соседние файлы в папке Лекции по информатике

Система связи служит для передачи

сообщений от отправителя к получателю.

Однако не всякое сообщение содержит

информацию. Информация – это совокупность

сведений об объекте или явлении, которые

увеличивают знания потребителя об

этом объекте или явлении.

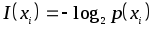

В математической теории связи (теории

информации) исходят из того, что в

некотором сообщении xi

количество информацииI(xi)

зависит не от её конкретного

содержания, степени важности и т.д., а

от того, каким образом выбирается данное

сообщение из общей совокупности возможных

сообщений.

В реальных условиях выбор конкретного

сообщения производится с некоторой

априорной вероятностью p(xi).

Чем меньше эта вероятность, тем больше

информации содержится в данном сообщении.

При

определении количества информации

исходят из следующих требований:

- Количественная

мера информации должна обладать

свойством аддитивности: количество

информации в нескольких независимых

сообщениях должно равняться сумме

количества информации в каждом сообщении. - Количество

информации о достоверном событии

(p(xi)=1)

должно равняться нулю, так как такое

сообщение не увеличивает наших знаний

о данном объекте или явлении.

Указанным

требованиям удовлетворяет логарифмическая

мера, определяемая формулой

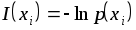

Чаще всего

логарифм берется с основанием 2, реже -с основаниемe:

натуральных единиц информации (нит).

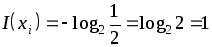

Одну двоичную единицу информации

содержит сообщение, вероятность

выбора которого равняется 1/2.

В этом случае

дв. ед. инф. (бит).

При применении натуральных логарифмов

одну натуральную единицу информации

содержит сообщение, вероятность выбора

которого равняется 1/e:

нат. ед. инф. (нит).

Учитывая, что в практике передачи и

преобразования информации широко

применяются двоичные символы, двоичная

логика, двоичные источники сообщений

и двоичные каналы передачи, наиболее

часто используется двоичная единица

информации(бит).

Хотя при определении количества

информации под сообщениями можно

понимать любые фразы или телеграфные

сообщения, мы здесь элементарными

сообщениями будем называть отдельные

буквы или слова. При использовании

двухуровневых дискретных сигналов,

например, мы будем пользоваться

элементарными двоичными сигналами “1”

и “0”, называя их буквами. Таким образом,

алфавит двоичного источника состоит

всего из двух букв, из которых можно

строить более длинные комбинации,

называемые кодовыми словами.

Вопросы к разделу 1

- Что такое

информация ? Как определяется количество

информации в сообщении ? - Почему для

определении количества информации в

сообщении используется логарифмическая

мера ? - Какое

сообщение содержит одну двоичную

единицу информации ? - Какое

сообщение содержит одну натуральную

единицу информации ?

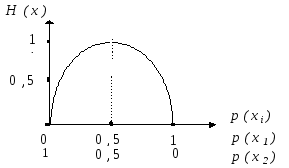

Энтропия дискретного источника с независимым выбором сообщений

В теории информации чаще всего необходимо

знать не количество информации I(xi),

содержащееся в отдельном сообщении, а

среднее количество информации в

одном сообщении, создаваемом источником

сообщений.

Размерность энтропии -количество единиц информации на символ.

Энтропия характеризует источник

сообщений с точки зрения неопределённости

выбора того или другого сообщения.

Рассмотрим свойства энтропии.

(т.е.

максимальная энтропия равна логарифму

от объёма алфавита).

Например,

при k=2(двоичный источник)

бит.

Эти свойства энтропии иллюстрируются

следующим образом.

Пусть имеется двоичный источник

сообщений, т.е. осуществляется выбор

всего двух букв (k=2):x1

иx2 ,

p(x1)+

p(x2)=

1.

Таким образом, укрупнение алфавита

привело к увеличению энтропии в nраз, так как теперь уже слово включает

в себя информациюnбукв двоичного источника. Тем самым

доказывается свойство аддитивности

энтропии.

Термин “энтропия” заимствован из

термодинамики и применительно к технике

связи предложен американским учёным

К.Шенноном, в трудах которого были

заложены основы теории информации

(математической теории связи).

В каком виде существует информация?

Информация может

существовать в виде:

- текстов,

рисунков, чертежей, фотографий; - световых

или звуковых сигналов; - электрических

и нервных импульсов; - запахов

и вкусовых ощущений; - хромосом, посредством

которых передаются по наследству

признаки и свойства организмов и т.д.

Предметы, процессы,

явления материального или нематериального

свойства, рассматриваемые с точки зрения

их информационных свойств, называются

информационными объектами.

Как передаётся информация?

Информация

передаётся в форме сообщений

от некоторого источника

информации к её приёмнику

посредством канала

связи между

ними. Источник посылает передаваемое

сообщение,

которое кодируется

в передаваемый сигнал.

Этот сигнал посылается по каналу

связи. В

результате в приёмнике появляется

принимаемый

сигнал,

который декодируется

и становится принимаемым

сообщением.

- Cообщение,содержащее информацию о прогнозе

погоды, передаётся приёмнику(телезрителю)от источника—

специалиста-метеорологапосредством

канала связи— телевизионной

передающей аппаратуры и телевизора. - Живое существо

своими органами чувств(глаз, ухо,

кожа, язык и т.д.)воспринимает информацию

из внешнего мира,перерабатывает

еёв определенную последовательность

нервных импульсов,передаетимпульсы

по нервным волокнам,хранитв памяти

в виде состояния нейронных структур

мозга,воспроизводитв виде звуковых

сигналов, движений и т.п.,используетв процессе своей жизнедеятельности.

Передача

информации по каналам связи часто

сопровождается воздействием помех,

вызывающих искажение

и потерю информации.

Как измеряется количество информации?

Какое

количество информации содержится, к

примеру, в тексте романа “Война и

мир”, во фресках Рафаэля или в

генетическом коде человека? Ответа на

эти вопросы наука не даёт и, по всей

вероятности, даст не скоро. А

возможно ли объективно измерить

количество информации?

Важнейшим результатом теории информации

является следующий вывод:

В

настоящее время получили распространение

подходы к определению понятия “количество

информации”, основанные на том, что

информацию, содержащуюся в сообщении,

можно нестрого трактовать в смысле её

новизны или, иначе, уменьшения

неопределённости наших знаний об

объекте.

Эти подходы используют математические

понятия вероятности

и логарифма.

В

качестве единицы информации Клод Шеннон

предложил принять один бит

(англ.

bit

— binary

digit

— двоичная цифра).

Бит

— слишком мелкая единица измерения. На

практике чаще применяется более крупная

единица — байт,

равная восьми

битам. Именно

восемь битов требуется для того, чтобы

закодировать любой из 256 символов

алфавита клавиатуры компьютера (256=28).

Широко

используются также ещё более

крупные производные единицы информации:

- 1

Килобайт (Кбайт) = 1024 байт = 210

байт, - 1

Мегабайт (Мбайт) = 1024 Кбайт = 220

байт, - 1 Гигабайт (Гбайт)

= 1024 Мбайт = 230 байт.

В последнее время

в связи с увеличением объёмов обрабатываемой

информации входят в употребление такие

производные единицы, как:

- 1

Терабайт (Тбайт) = 1024 Гбайт = 240

байт, - 1 Петабайт (Пбайт)

= 1024 Тбайт = 250 байт.

За

единицу информации можно было бы выбрать

количество информации, необходимое для

различения, например, десяти равновероятных

сообщений. Это будет не двоичная (бит),

а десятичная (дит)

единица информации.